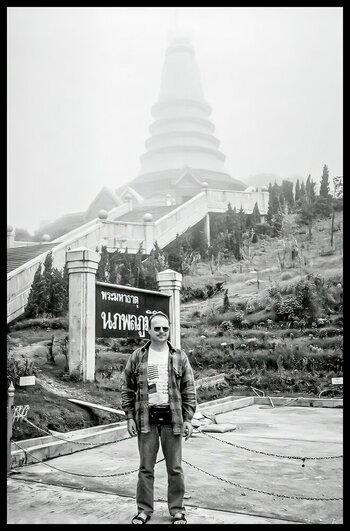

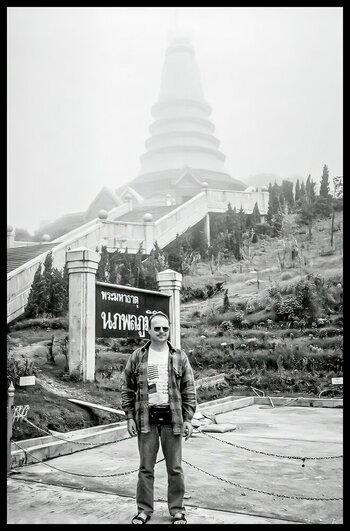

Ich habe ein 30 Jahre altes Foto vor Jahren eingescannt. Neulich in meinem Club wurden die Topaz Programme besprochen und jetzt habe ich es mit Lightroom und Topaz Gigapixel AI nochmals überarbeitet:

Das Bild ist vor rund 30 Jahren auf dem Doi Intanon entstanden, mit 2565m der höchste Berg Thailands.

Das Original mit 1140x1716 Pixel und 1,11 MB, dann die SW Bearbeitung mit 2208x3350 Pixel und 3,24 MB.

Es ist in meinen Augen schon klasse was mit AI alles machbar ist.

Original

SW Bearbeitung und mit Gigapixel AI vergrößert

Das Bild ist vor rund 30 Jahren auf dem Doi Intanon entstanden, mit 2565m der höchste Berg Thailands.

Das Original mit 1140x1716 Pixel und 1,11 MB, dann die SW Bearbeitung mit 2208x3350 Pixel und 3,24 MB.

Es ist in meinen Augen schon klasse was mit AI alles machbar ist.

Original

SW Bearbeitung und mit Gigapixel AI vergrößert

Eine Kollege kaufte sich die RTX4070, klagt aber dass die Perfomance kaum besser als vorher sei, ich kann mir vorstellen dass noch verschiedene Einstellungen der Energiefunktionen und die Leistungskonfiguration der GraKa eine nicht unerhebliche Rolle spielen..