Das wird vermutlich mein letzter Thread für heuer werden. Vielleicht besteht Interesse an ein paar Informationen zum Thema Datenspeicherung.

Vor 4,5 Jahren hatte ich meinen letzten Homeserver gebaut. Ein Projekt daß ich damals auch dokumentierte. Mehr Info's dazu gibt es hier

Jetzt 4,5 Jahre später wurde es wieder einmal Zeit, eine neue Basis für die nächsten 4-5 Jahre zu schaffen um bequem und sicher das Thema Datenhandling abzuarbeiten.

Aufgrund der Anforderung, daß ich gerne mit virtuellen Maschinen arbeite, war mein "Datengrab" damals kein HomeNAS oder ähnliches System, sondern eine relativ starke PC Basis um auch diese Anforderung abdecken zu können (Zum Thema VM später mehr).

Das Resümee des alten Servers:

Die Anforderungen an den neuen Server waren nicht wirklich komplett anders.

Ein paar Punkte:

Das seit 5 Monaten laufende PC Studienprojekt daß ich schon mal wo anders kurz angesprochen hatte, geht jetzt bald in die Endphase. Von diesem Projekt habe ich sehr viele für mich neue Erkenntnisse zum Thema Daten, Ein/Ausgabeleistung und Netzwerkkonfiguration erhalten, die auch in den Homeserver eingeflossen sind.

(Die schnellere der beiden Workstations schafft es zum Beispiel 120 GB Daten in 6 Sekunden in den Hauptspeicher zu lesen. 120 GB ist die Größe einer üblichen SSD, bzw. war vor ein paar Jahren eine übliche Festplattengröße. In Fotografensprache: ca. 2700 RAWs einer D800 können in 6 Sekunden in den Hauptspeicher geladen werden)

Zurück zum Homeserver:

Diese Leistung ist nicht notwendig, sie ist sogar kontraproduktiv zu ein paar anderen Eigenschaften. Der Homeserver muß vor allem eines gut machen - sicher und stabil laufen. Zusammen mit einem guten Backupverfahren ein Garant für eine sorgenfreie Zeit.

Welche Komponenten sind es geworden und warum gerade diese?

CPU: Intel E3-1245v2

Diese CPU ist die Servervariante der aktuellen Desktop CPU-Serie i7-3770. Sie hat ECC Speicherunterstützung, kann ebenfalls 32 GB RAM ansprechen, unterstützt PCI 3.0, hat eine GPU am Chip, ist fast genauso schnell wie die Desktopvariante (100 MHz fehlen), hat einen sehr niedrigen Stromverbrauch im (sehr häufigen) Leerlauf von nur 1-2 Watt. Daß sie ca. 50 Euro billiger als die 3770 CPU ist, ist ebenenfalls schön.

Speicher: 4 x 8 GB Kingston unbuffered ECC DDR3

Man muß nur auf 2 Dinge besonders aufpassen. Es müssen bei dieser CPU unbuffered ECC Speicher sein (keine registered ECC) und sie sollten nicht über dual rank sein wenn man eine volle Bestückung anstrebt.

Motherboard:

Asus P8C WS. Dieses MB hat einen C216er Chipsatz und unterstützt (unbuffered) ECC Ram wenn eine entsprechende CPU wie zum Beispiel die E3-1245v2 drinnen ist. Das MB unterstützt auch PCI 3.0 (2 slots mit je x8 Anschluß) und USB 3.0 für etwas flottere USB Anbindung. Dazu hat es 2 x 1GBit/s Server Ethernet Anschlüsse (Server in diesem Zusammenhang bedeutet, daß die lokale CPU geringer belastet wird, wenn hohe Datenraten anliegen)

Netzwerkkarten

Um ausreichende Netzwerkleistung sicherzustellen, ist ein Intel i340 Serveradapter mit 4 x 1Gbit/sec eingebaut. Da derzeit 10 Gb/sec Ethernet Controller sehr teuer sind und die dazupassenden 10Gb/s Switches unbezahlbar sind, gehe ich für die nächsten Jahre den Weg der Zusammenfassung mehrerer Gigabit Ports um in etwa die Leistung einer schnellen lokalen SSD von 400-450 MByte/sec zu erreichen.

Raid Controller:

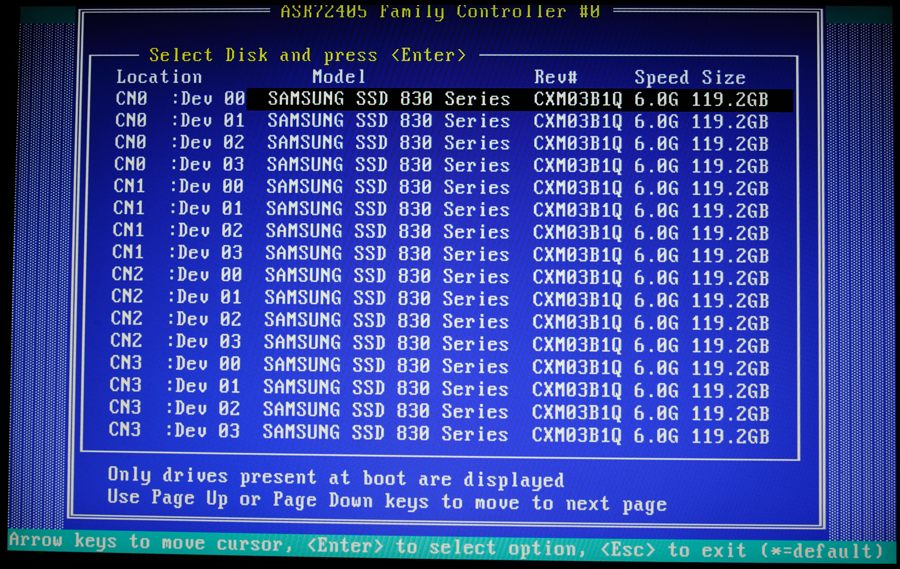

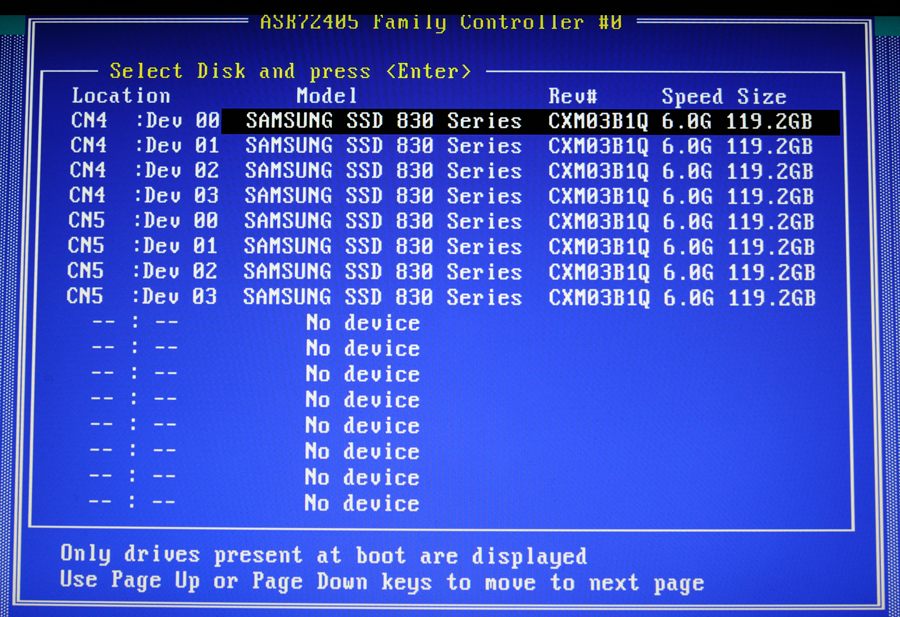

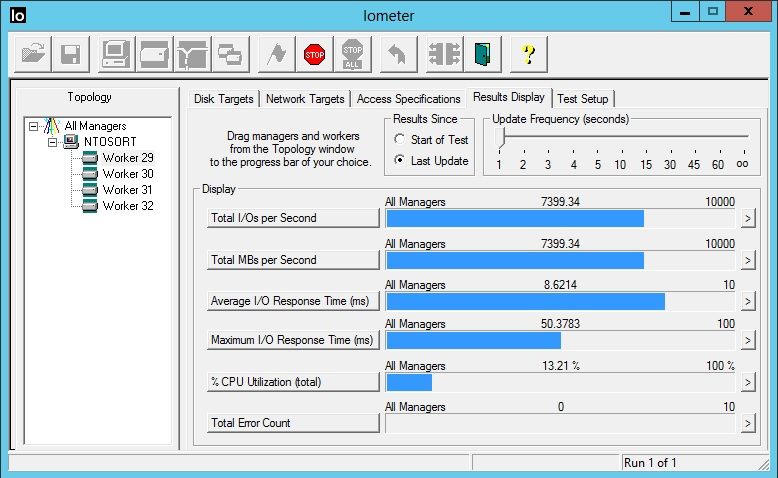

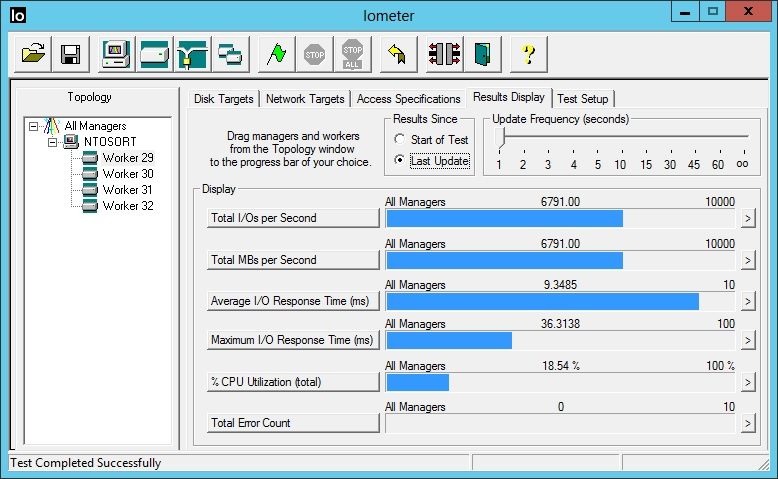

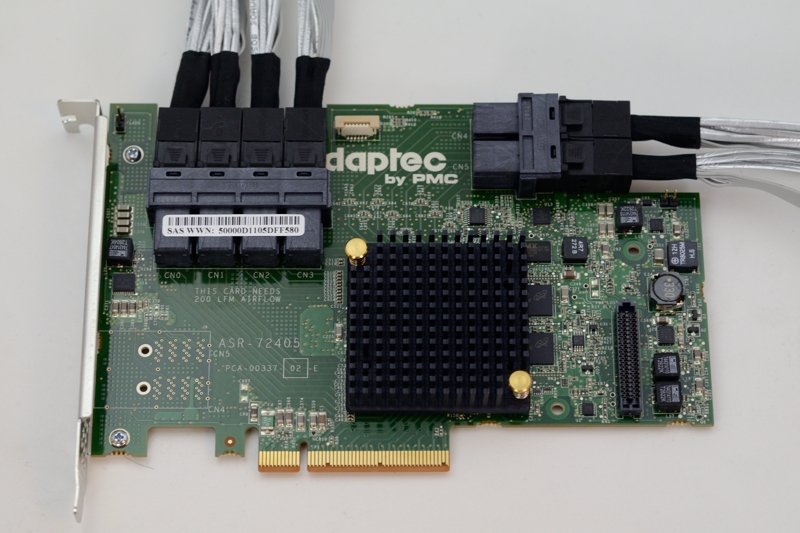

Hier habe ich extra auf den neuen Adaptec 72405 gewartet, der einige gute Themen zusammenfasst. Er ist mit einem neuen Raidcontroller Chip ausgestattet, der nicht so elends langsam ist, wie die Vorgeneration (alle Raidcontroller vor Frühjahr 2012 sind nach aktuellen Maßstäben sehr langsam). Des weiteren hat er PCI 3.0 Unterstützung und kann diese auch gut ausnutzen. Mit 24 SSD angefeuert, kann er von den 8 GB/sec die theoretisch über einen x8 PCI 3.0 Slot transferiert werden können, ca. 7 GB/Sec erreichen. Werte von über 3 GB/sec mit Festplatten sind somit locker abgedeckt (im JBOD Betrieb). Im Raid5 Betrieb ist er natürlich langsamer, aber ein 12 Platten Raid5 kann locker über 1 GB/sec lesen und schreiben. Der Adaptec Controller hat noch etwas Interessantes. Das Modul AFM-700 ist eine kleiner Kondensator und ein Flashspeichermodul. Der Kondensator wird innerhalb von 5 min voll aufgeladen. Sollte es einen Stromausfall geben, ist genügend Strom im Kondesator, um die 1 GB Bufferdaten die der Controller im RAM hat in das Flashmodul zu schreiben und dann dreht sicht der Raidcontroller auch ab. Damit ist dieser Speicherzustand auch über Tage aufrecht und nicht wie bei einer Batterie nach einiger Zeit auch futsch.

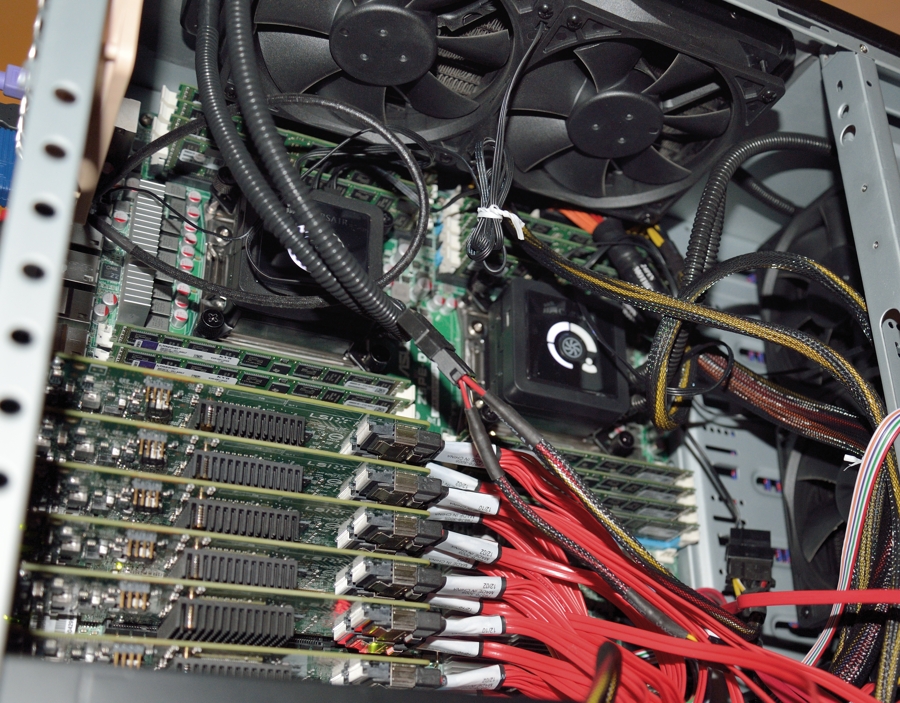

Wer absolute Performance mit SSDs sucht, ist besser bei LSI aufgehoben, aber die haben nur 8 SATA/SAS Ports pro Karte. (Ich habe in der schnellen Workstation 6 dieser Controller im Parallellbetrieb, die kleine hat deren 4)

Festplatten:

Da hat wohl jeder seine Favoriten. Ich bin seit Jahren mit den Western Digital Green Platten ganz gut aufgehoben. Sie brauchen wenig Strom, sind recht günstig, der wenige Strom hält sie kühl. Im alten Server kamen die Platten nie über 27 Grad. WD hat neue Platten für NAS vorgestellt. Die WD Red Serie, die extra Dauerlauf geeignet ist, eine längere Garantie hat und nochmals etwas weniger Strom braucht. Ich habe jeweils 12 Stück der aktuellen Green und Red Platten mit jeweils 3 TB eingebaut. Die RED Platten waren eine Zeitlang nicht verfügbar, bzw. war mir der Preisunterschied damals zu hoch.

Gehäuse:Ich wollte irgendwas Kompaktes und Leises haben. Ich habe mich für das Lian-Li V343 entschieden und habe noch 6 Raid Plattenkörbe von LianLi für jeweils 4 HDs dazugenommen. Im Prinzip gefällt mir das würfelförmige Layout sehr. Es hat nur einen Nachteil, auf den ich erst beim Einbau gestoßen bin. Die Befestigungsschrauben der FEstplattenkörbe in der Mitte des Gehäuses kann man so gut wie nicht erreichen. Nach einigem Herumprobieren habe ich die Trennwand in der Geäusemitte mit einem Bosch Ultraschallschneider etwas aufgeschnitten um besser dazuzukommen. Die Japaner scheinen viel kleiner Finger als ich zu haben ... Ventilatoren sind von der österreichischen Firma Noctua. Die sind mehr oder weniger unhörbar

Stromversorgung:

Von meinem anderen Projekt ist mir noch ein Enermax Platimax 600W übergeblieben, daß ich hier eingebaut habe. Es hat einen hohen Wirkungsgrad auch bei niedriger Auslastung und der Lüfter ist leise.

Ein Bild (aus der Testphase)

Er schaut wirklich nach nichts Besonderem aus. Ein schwarzer Würfel mit ca. 45 cm Seitenlänge, der halt vor sich hinsummt. Er ist so leise, daß er unter dem Tisch stehen kann und beim Arbeiten und Telefonieren nicht stört. Trotzdem wandert er zum alten Server in den Keller da er sowieso "headless" betrieben wird (keine Tastatur und Bildschirm).

Ein paar Setup Infos und Leistungswerte kommen noch.

Liebe Grüße,

Andy

Vor 4,5 Jahren hatte ich meinen letzten Homeserver gebaut. Ein Projekt daß ich damals auch dokumentierte. Mehr Info's dazu gibt es hier

Jetzt 4,5 Jahre später wurde es wieder einmal Zeit, eine neue Basis für die nächsten 4-5 Jahre zu schaffen um bequem und sicher das Thema Datenhandling abzuarbeiten.

Aufgrund der Anforderung, daß ich gerne mit virtuellen Maschinen arbeite, war mein "Datengrab" damals kein HomeNAS oder ähnliches System, sondern eine relativ starke PC Basis um auch diese Anforderung abdecken zu können (Zum Thema VM später mehr).

Das Resümee des alten Servers:

- Intel 4 Kern CPU, 8 GB, 3Ware Raid Controller mit 12 SATA ports

- Zu Beginn 12 x 1 TB Western Digital Green Platten, Vor ca. 1 Jahr Austausch auf 12 x 2 TB WD Green Platten. Die 1 TB Platten werden im Backupbetrieb weiterverwendet.

- Der Stromverbrauch lag im Schnitt unter 100 Watt wenn alle Platten laufen und die CPU idle ist. Bis 10% CPU Last verändert sich der Stromverbrauch nicht. Ist die CPU voll ausgelastet waren es ca. 180 Watt, aber das kam so gut wie nie vor.

- Betriebsstörungen: Einige Wenige (es haben sich Kabel gelockert und die entsprechende Platte war nicht mehr online und das Raid ging in der "degraded" Modus mit reduzierter Leistung und reduzierter Sicherheit)

- Datenverluste in 4,5 Jahren: 0

- Defekte Platten: 0

Die Anforderungen an den neuen Server waren nicht wirklich komplett anders.

Ein paar Punkte:

- Mehr und größere Platten

- Eine modernere CPU, die den Grafikteil gleich eingebaut hat (Stromsparender) und die Virtualisierung besser unterstützt. Hier kamen in den letzten Jahren von Intel neue Eigenschaften dazu (SLAT und VT-d um nur 2 zu nennen).

- Den Hauptspeicher mit ECC Unterstützung

- Dramatisch bessere Netzwerkleistung, die lokale Festplatten und SSDs für die Datenhaltung überflüssig machen (Boot SSD ist nach wie vor sinnvoll)

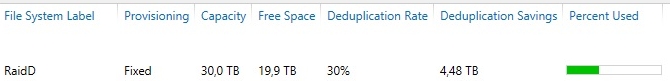

- Automatische Deduplizierung von identen Daten (jedoch nicht auf Basis von ganzen Dateien, sondern auf Clusterebene. Ist effizienter)

Das seit 5 Monaten laufende PC Studienprojekt daß ich schon mal wo anders kurz angesprochen hatte, geht jetzt bald in die Endphase. Von diesem Projekt habe ich sehr viele für mich neue Erkenntnisse zum Thema Daten, Ein/Ausgabeleistung und Netzwerkkonfiguration erhalten, die auch in den Homeserver eingeflossen sind.

(Die schnellere der beiden Workstations schafft es zum Beispiel 120 GB Daten in 6 Sekunden in den Hauptspeicher zu lesen. 120 GB ist die Größe einer üblichen SSD, bzw. war vor ein paar Jahren eine übliche Festplattengröße. In Fotografensprache: ca. 2700 RAWs einer D800 können in 6 Sekunden in den Hauptspeicher geladen werden)

Zurück zum Homeserver:

Diese Leistung ist nicht notwendig, sie ist sogar kontraproduktiv zu ein paar anderen Eigenschaften. Der Homeserver muß vor allem eines gut machen - sicher und stabil laufen. Zusammen mit einem guten Backupverfahren ein Garant für eine sorgenfreie Zeit.

Welche Komponenten sind es geworden und warum gerade diese?

CPU: Intel E3-1245v2

Diese CPU ist die Servervariante der aktuellen Desktop CPU-Serie i7-3770. Sie hat ECC Speicherunterstützung, kann ebenfalls 32 GB RAM ansprechen, unterstützt PCI 3.0, hat eine GPU am Chip, ist fast genauso schnell wie die Desktopvariante (100 MHz fehlen), hat einen sehr niedrigen Stromverbrauch im (sehr häufigen) Leerlauf von nur 1-2 Watt. Daß sie ca. 50 Euro billiger als die 3770 CPU ist, ist ebenenfalls schön.

Speicher: 4 x 8 GB Kingston unbuffered ECC DDR3

Man muß nur auf 2 Dinge besonders aufpassen. Es müssen bei dieser CPU unbuffered ECC Speicher sein (keine registered ECC) und sie sollten nicht über dual rank sein wenn man eine volle Bestückung anstrebt.

Motherboard:

Asus P8C WS. Dieses MB hat einen C216er Chipsatz und unterstützt (unbuffered) ECC Ram wenn eine entsprechende CPU wie zum Beispiel die E3-1245v2 drinnen ist. Das MB unterstützt auch PCI 3.0 (2 slots mit je x8 Anschluß) und USB 3.0 für etwas flottere USB Anbindung. Dazu hat es 2 x 1GBit/s Server Ethernet Anschlüsse (Server in diesem Zusammenhang bedeutet, daß die lokale CPU geringer belastet wird, wenn hohe Datenraten anliegen)

Netzwerkkarten

Um ausreichende Netzwerkleistung sicherzustellen, ist ein Intel i340 Serveradapter mit 4 x 1Gbit/sec eingebaut. Da derzeit 10 Gb/sec Ethernet Controller sehr teuer sind und die dazupassenden 10Gb/s Switches unbezahlbar sind, gehe ich für die nächsten Jahre den Weg der Zusammenfassung mehrerer Gigabit Ports um in etwa die Leistung einer schnellen lokalen SSD von 400-450 MByte/sec zu erreichen.

Raid Controller:

Hier habe ich extra auf den neuen Adaptec 72405 gewartet, der einige gute Themen zusammenfasst. Er ist mit einem neuen Raidcontroller Chip ausgestattet, der nicht so elends langsam ist, wie die Vorgeneration (alle Raidcontroller vor Frühjahr 2012 sind nach aktuellen Maßstäben sehr langsam). Des weiteren hat er PCI 3.0 Unterstützung und kann diese auch gut ausnutzen. Mit 24 SSD angefeuert, kann er von den 8 GB/sec die theoretisch über einen x8 PCI 3.0 Slot transferiert werden können, ca. 7 GB/Sec erreichen. Werte von über 3 GB/sec mit Festplatten sind somit locker abgedeckt (im JBOD Betrieb). Im Raid5 Betrieb ist er natürlich langsamer, aber ein 12 Platten Raid5 kann locker über 1 GB/sec lesen und schreiben. Der Adaptec Controller hat noch etwas Interessantes. Das Modul AFM-700 ist eine kleiner Kondensator und ein Flashspeichermodul. Der Kondensator wird innerhalb von 5 min voll aufgeladen. Sollte es einen Stromausfall geben, ist genügend Strom im Kondesator, um die 1 GB Bufferdaten die der Controller im RAM hat in das Flashmodul zu schreiben und dann dreht sicht der Raidcontroller auch ab. Damit ist dieser Speicherzustand auch über Tage aufrecht und nicht wie bei einer Batterie nach einiger Zeit auch futsch.

Wer absolute Performance mit SSDs sucht, ist besser bei LSI aufgehoben, aber die haben nur 8 SATA/SAS Ports pro Karte. (Ich habe in der schnellen Workstation 6 dieser Controller im Parallellbetrieb, die kleine hat deren 4)

Festplatten:

Da hat wohl jeder seine Favoriten. Ich bin seit Jahren mit den Western Digital Green Platten ganz gut aufgehoben. Sie brauchen wenig Strom, sind recht günstig, der wenige Strom hält sie kühl. Im alten Server kamen die Platten nie über 27 Grad. WD hat neue Platten für NAS vorgestellt. Die WD Red Serie, die extra Dauerlauf geeignet ist, eine längere Garantie hat und nochmals etwas weniger Strom braucht. Ich habe jeweils 12 Stück der aktuellen Green und Red Platten mit jeweils 3 TB eingebaut. Die RED Platten waren eine Zeitlang nicht verfügbar, bzw. war mir der Preisunterschied damals zu hoch.

Gehäuse:Ich wollte irgendwas Kompaktes und Leises haben. Ich habe mich für das Lian-Li V343 entschieden und habe noch 6 Raid Plattenkörbe von LianLi für jeweils 4 HDs dazugenommen. Im Prinzip gefällt mir das würfelförmige Layout sehr. Es hat nur einen Nachteil, auf den ich erst beim Einbau gestoßen bin. Die Befestigungsschrauben der FEstplattenkörbe in der Mitte des Gehäuses kann man so gut wie nicht erreichen. Nach einigem Herumprobieren habe ich die Trennwand in der Geäusemitte mit einem Bosch Ultraschallschneider etwas aufgeschnitten um besser dazuzukommen. Die Japaner scheinen viel kleiner Finger als ich zu haben ... Ventilatoren sind von der österreichischen Firma Noctua. Die sind mehr oder weniger unhörbar

Stromversorgung:

Von meinem anderen Projekt ist mir noch ein Enermax Platimax 600W übergeblieben, daß ich hier eingebaut habe. Es hat einen hohen Wirkungsgrad auch bei niedriger Auslastung und der Lüfter ist leise.

Ein Bild (aus der Testphase)

Er schaut wirklich nach nichts Besonderem aus. Ein schwarzer Würfel mit ca. 45 cm Seitenlänge, der halt vor sich hinsummt. Er ist so leise, daß er unter dem Tisch stehen kann und beim Arbeiten und Telefonieren nicht stört. Trotzdem wandert er zum alten Server in den Keller da er sowieso "headless" betrieben wird (keine Tastatur und Bildschirm).

Ein paar Setup Infos und Leistungswerte kommen noch.

Liebe Grüße,

Andy